KI-gestützte Programmierung: Risiken, aber auch viel Potenzial

Ein weiteres Risiko sind Datenlecks. Die Anbieter stellen ihre KI-gestützten Codierungsassistenten in der Regel „as a service“ zur Verfügung. Die in einer Eingabe-Aufforderung gesendeten Informationen können dadurch sensible Daten enthalten – etwa Tastatureingaben und andere Metadaten aus dem Projekt sowie Quellcode-Abschnitte, Kommentare und Telemetriedaten. Diese Daten sind sichtbar, wenn die Eingabe-Aufforderungen erstellt wurden, bevor sie am API-Endpunkt ankommen. Das Unternehmen hat keinen Einfluss darauf, wie diese Informationen erfasst, gespeichert oder später von den Drittanbietern verwendet werden – beispielsweise für interne Schulungen. Möglich ist zudem, dass der KI-Trainingsprozess nicht rein automatisiert abläuft, sondern bestimmte Eingaben des Tools von Menschen überprüft werden.

Trotz der Risiken ist das Potenzial enorm

Ein grundsätzliches Verbot von Generative-AI-Assistenten kann allerdings ebenfalls zu Problemen führen. So ist wahrscheinlich, dass die Programmierer die Tools ohne das Wissen der IT-Abteilung weiterverwenden. Solche Reaktionen ließen sich während der Anfänge des Cloud Computing vielerorts beobachten. Und vor allem sollte Unternehmen klar sein: KI-gestützte Tools haben im ausgereiften Stadium das Potenzial, die Softwareentwicklung deutlich zu optimieren.

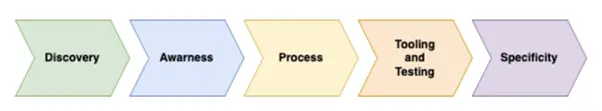

Wie bei jeder neuen Technologie kommt es auch beim Einsatz von KI darauf an, durchdachte Konzepte auf der Basis bestehender Risiken zu entwickeln.Und es gibt bereits eine Vielzahl von Werkzeugen und Vorgehensweisen, um diese Gefahren einzudämmen. Entscheidend ist eine Strategie, die die Verwendung bestimmter KI-Tools bei gleichzeitiger Risikominimierung vorsieht. Das heißt, die Security-Experten sollten die mit dem Einsatz von LLM verbundenen Gefahren genau kennen, um die nötigen Gegenmaßnahmen ergreifen zu können. Ziel sollte sein, das Potenzial der Generative-AI-Technologie ohne Sicherheitseinbußen auszuschöpfen. Dazu zählt auch, mögliche Probleme im Einsatz einzukalkulieren und den Output der KI zum Erstellungszeitpunkt als Alpha- oder Beta-Qualität einzustufen. Grundsätzlich empfiehlt es sich, dass die Security-Verantwortlichen eng mit den Programmierern zusammenarbeiten, um die Tools sicher zu implementieren. Und alle, auch die Entwickler, sollten über die bestehenden Risiken informiert sein.

Zur Risikominimierung empfiehlt sich folgende Vorgehensweise:

In Anbetracht der Risiken und des Fehlerpotenzials von KI-gestützten Codierungsassistenten ist es sinnvoll, den von ihnen erstellten Code wie Beiträge von Dritten zu behandeln. Und das, auch wenn ein KI-Tools reibungslos funktioniert und keine Probleme macht – eine Sicherheitsprüfung ist immer ratsam.

Fazit

KI-gestützte Tools können Programmierer bei ihrer Arbeit unterstützen und die Produktivität positiv beeinflussen. Es bleibt jedoch abzuwarten, wie sich ihr Einsatz auf die Sicherheit auswirken wird. Neue Technologien bieten nicht selten Überraschungen, die die Sicherheit gefährden. Hinzu kommen die rechtlichen Fragen: LLMs nutzen Inhalte, die Menschen irgendwann einmal verfasst haben – und für deren Nutzung wohl kaum jemand damals die Einwilligung erteilt hat. Erste rechtlichen Anfechtungen gab es bereits, und es ist davon auszugehen, dass es in Zukunft mehr werden.

Nichtsdestotrotz: KI-gestützte Tools und Codierungsassistenten sind aus dem beruflichen Alltag kaum noch wegzudenken. Wir haben gar keine andere Wahl, als uns mit ihnen grundlegend auseinanderzusetzen und eine klare Haltung in Bezug auf ihren Einsatz zu entwickeln.