Die Vorteile von generativer KI sicher im Unternehmen nutzen

Autor/Redakteur: Daniel Fallmann, Gründer und Geschäftsführer von Mindbreeze/gg

Generative KI beziehungsweise Large Language Models haben es mit Tools wie ChatGPT (Chat Generative Pre-trained Transformer) innerhalb kürzester Zeit geschafft, ein wichtiger Bestandteil des Privat- und Arbeitslebens vieler Menschen zu werden. Tätigkeiten, die früher dem menschlichen Verstand vorbehalten waren, wie beispielsweise das Erstellen von Texten, das Zusammenfassen von Inhalten oder Brainstorming, erledigt die KI heute auf Knopfdruck.

Die Akzeptanz dieser fortschrittlichen Anwendungen ist dabei hoch. Das geht aus der Studie „Why consumers love generative AI” des Capgemini Research Institutes hervor. So verfolgen 51 Prozent der Verbraucher weltweit die neuesten Trends rund um generative KI und haben entsprechende Tools auch bereits ausprobiert.

Doch zunächst: Was ist generative KI und was sind Large Language Models?

Generative KI (Generative AI, GenAI) ist eine innovative Technologie, die KI und Algorithmen des Machine Learnings einsetzt, um Maschinen beizubringen, aus vorhandenen Texten, Audiodateien, Bildern oder Originalmustern eigenständig zu „lernen“ um dann auf Basis dieser gelernten Modelle neue Inhalte zu erschaffen. Dabei lernen die Systeme auf Basis von Trainingsdaten Muster zu erkennen und Inhalte zu erstellen, die Menschen letztendlich als authentisch wahrnehmen.

Im Zusammenhang mit textbasierten Inhalten spricht man von Large Language Models. Diese basieren auf neuronalen Netzwerken mit Transformer-Architektur und dienen ganz konkret der Verarbeitung der natürlichen Sprache in Texten. Das geht dabei weit über das Verstehen von einzelnen Wörtern hinaus. Es geht darum, gesamte Sätze und Texte und ihre semantische Bedeutung sowie die Intention dahinter zu ermitteln, zu verstehen, zusammenzufassen und neue zu generieren – und das trotz der üblichen menschlichen Fehler (etwa Tippfehler), Dialekte oder der Mehrdeutigkeit der menschlichen Sprache. Integriert in spezielle Anwendungen sind sie damit in der Lage, Inhalte und ihre Bedeutung korrekt zu verstehen und adäquat auf Abfragen zu reagieren, und schaffen damit eine einzigartige dialogbasierte Kommunikation.

Generative KI birgt damit ein enormes Transformationspotenzial. Gerade wenn es um den professionellen Einsatz in Unternehmen geht, ergeben sich aber zahlreiche Herausforderungen.

Eine große Hürde für Unternehmen besteht darin, sicherzustellen, dass generative KI, im speziellen Large Language Models, exakte und vertrauenswürdige Inhalte generieren. Eine Möglichkeit, diesem Risiko entgegenzuwirken, ist die Anbindung zuverlässiger Datenquellen. Dies gelingt beispielsweise durch den Einsatz von innovativen Wissensmanagementlösungen, sogenannten Insight Engines. Die Integration von vortrainierten Large Language Models in den Kern dieser Systeme (via Prompt Engineering) hilft dabei die Schwächen der Modelle auszugleichen. Während Large Language Models über gute Fähigkeiten im Bereich der Verarbeitung und Generierung der menschlichen Sprache verfügen, überwinden Insight Engines die genannten Hürden durch Datenaktualität, Konnektivität und Validierung der Quellen. Das Ergebnis ist die bestmögliche Basis für Generative AI im Unternehmenskontext.

Umfassender Zugang zu relevanten Informationen

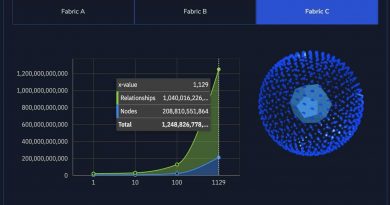

Insight Engines kombinieren klassische Enterprise-Search-Technologien mit Künstlicher Intelligenz und ermöglichen einen raschen, ressourceneffizienten Zugriff auf Unternehmensdaten. Dazu führen sie alle Informationen aus den unterschiedlichen Unternehmensdatenquellen in einen Suchindex zusammen. Kommt es zu einer Suchanfrage, durchsucht die Insight Engine angebundene Fachanwendungen oder Datenbanken, analysiert die Inhalte, extrahiert die abgefragten Informationen und stellt sie entsprechend aufbereitet dem Anwender zur Verfügung.

Im Gegensatz zu Anwendungen wie ChatGPT, deren Datenbasis auf öffentlich zugänglichen Informationen beruht, verwenden Insight Engines die vorhandenen und vorab angebundenen Unternehmensdaten als Basis für maschinelles Lernen. Das intergierte Large Language Model lernt damit von den spezifischen im Unternehmen vorhanden Daten sowie den Anwendern und ihrem Verhalten. Die Integration macht den Datenursprung nachvollziehbar, verschafft Anwendern die Möglichkeit sensible und geschäftskritische Informationen abzufragen und sorgt für fundierte sowie personalisierte Ergebnisse.

Welches Sprachmodell dabei eingesetzt wird, ist bei vielen Insight Engine Hersteller dem Anwender überlassen. Meist können Unternehmen durch den Einsatz von Transformer Modellen sowie Schnittstellen zu offenen Standards jedes beliebige Modell verwenden, sei es ein selbst erstelltes Modell oder ein evaluiertes Modell aus Communities wie Hugging Face.

Kampf gegen Datenhalluzination durch Validierung und Quellenangaben

Sogenannte Datenhalluzination ist eines der häufigsten und größten Risiken im Zusammenhang mit öffentlichen GenAI Modellen. Dabei handelt es sich um falsche Antworten und Erkenntnisse, die auf den ersten Blick durchaus vertrauenswürdig erscheinen. So erfinden öffentlich verfügbare Modelle Antworten, Zitate und Quellen, wenn sie keine belgebare Information finden. Diese Falschinformationen bergen ein enormes Risiko, da diese selbst für Experten häufig schwer zu erkennen sind.

Die Validierung der Quellen, sowie Relevanzmodelle und die Verwendung hochwertiger Daten zum Trainieren der Modelle, helfen Unternehmen im Kampf gegen die Datenhalluzination. Auch wenn die Ergebnisse beim Einsatz von Insight Engines ohnehin aus den Unternehmensdaten entspringen, können Nutzer die von der KI gegebenen Antworten zu jedem Zeitpunkt validieren. Während Anwendungen wie ChatGPT oder Google Bard keine Angabe über die Herkunft beziehungsweise den exakten Ursprung der Daten machen, stellen Insight Engies zusätzlich zum Ergebnis beziehungsweise der Antwort Quelleninformationen bereit. Anwender wissen damit jederzeit, woher die Inhalte stammen und können diese bei Bedarf verifizieren.

Antworten im Kontext und Relevanzmodell

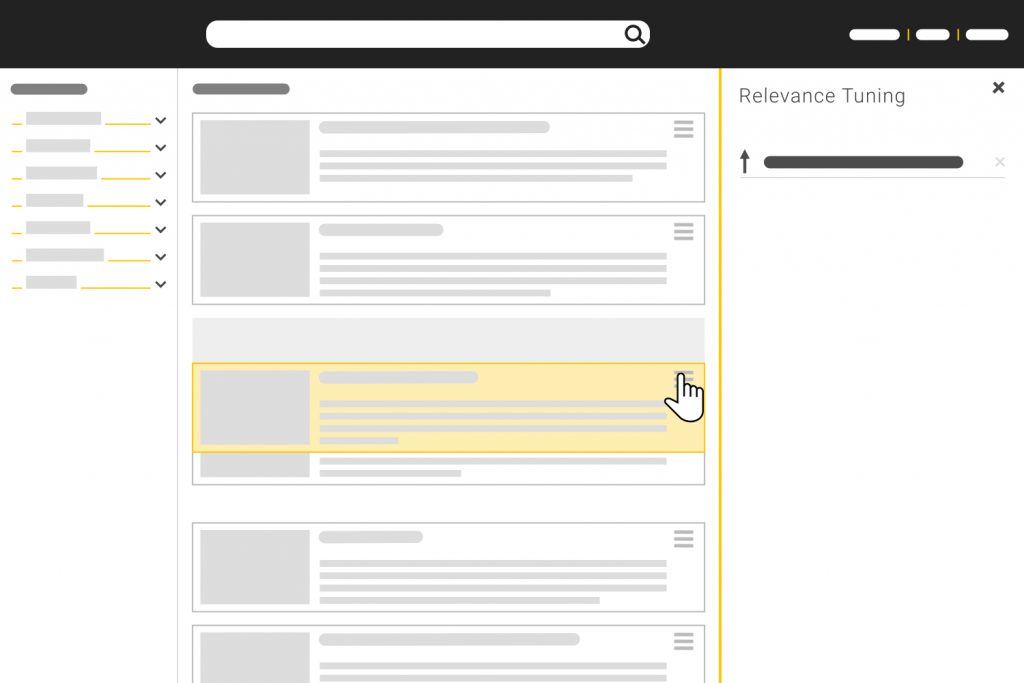

Insight Engines passen dabei sowohl die Ergebnisse als auch die Darstellung an die spezifischen Anforderungen und Autorisierungen des Anwenders an. Entsprechend den Zugriffsrechten breitet die Lösung die relevanten Informationen, angereichert um kontextspezifische Inhalte, den Anwendern in personalisierten Gesamtsichten (Holistic Views) auf.

Möglich ist dies dank verschiedenen Methoden des maschinellen Lernens, insbesondere dem Modell der neuronalen Netze (Deep-Learning). Diese Technologien nutzt die Insight Engine, um ihre User sowie ihr individuelles Nutzerverhalten zu analysieren und dadurch ihr Wissen zu erweitern, ihre Leistung zu optimieren und anwenderspezifische Relevanzmodelle zu erstellen. Auf Basis vorangegangener Suchabfragen, ihrer Intention und Interaktionen mit Treffern lassen sich Ergebnisse klassifizieren, kategorisieren und entsprechend kontextspezifisch, personalisiert und proaktiv anzeigen

Die aktuelle Entwicklung von Generativer KI und Large Language Models trägt maßgeblich zu einer Beschleunigung der Arbeitswelt bei. Die Technologie hat das Potenzial, Arbeitsschritte zu automatisieren, Menschen von Routinearbeiten zu entlasten und so neue Freiräume für kreative Arbeit und Innovation zu schaffen. Während zahlreiche, vor allem öffentliche Modelle ein enormes Risiko für Unternehmen darstellen, wird durch eine Integration von Generativer KI in Anwendungen wie Insight Engines eine vertrauenswürdige Möglichkeit geschaffen diese Technologien sicher zu nutzen und von ihnen zu profitieren.