Daten konsolidieren, analysieren, handeln

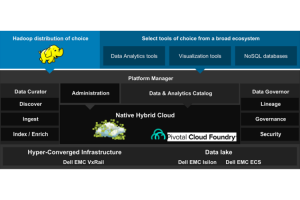

Teams und einzelne Analysten aus den verschiedenen Fachabteilungen sind damit in der Lage, in voneinander unabhängigen Bereichen des Data Lake zu arbeiten, ohne die Abläufe von Kollegen zu beeinträchtigen. In diesen Bereichen können Mitarbeiter im Data Lake vorhandene sowie weitere externe Daten durchsuchen, aufbereiten und auswerten. Der Datenzugriff wird dabei durch Richtlinien gesteuert. Damit kann auch die Datenherkunft bei externen Quellen und die Ende-zu-Ende-Sicherheit auf Datenebene überwacht und nachvollzogen werden.

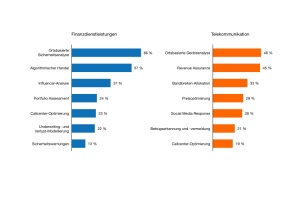

In Telekommunikationsunternehmen etwa liefert ein Data Lake – im optimalen Fall in Echtzeit – Einblicke in die Netzwerkauslastung. Techniker sind mit diesen Daten in der Lage, die Infrastruktur weiter zu optimieren. Nutzungstrends und demografische Analysen liefern Ansatzpunkte für ein proaktives Marketing, um neue Kunden zu gewinnen und zusätzliche Marktsegmente zu erschließen. Finanzdienstleister nutzen neue Technologien, um in allen Fachabteilungen ihre kundenzentrierte operative Effizienz zu steigern und neue Umsatzpotenziale zu erschließen. Sie setzen Vertriebsmaßnahmen um, testen deren Wirkung und optimieren ihre Aktivitäten immer weiter, um die gewünschten Ergebnisse zu erzielen. In schnellen Zyklen werden neue Finanzprodukte im Markt eingeführt und deren Erfolg permanent überprüft. Zudem ermöglicht die Datenanalyse schneller und genauer als bislang, mögliche Anlagerisiken zu erkennen und rechtzeitig gegenzusteuern.

Ergebnisse ihrer Arbeiten können die Teams und Analysten in einem Data and Analytics Catalog veröffentlichen. Die besten Möglichkeiten, die Vorteile der Datenanalyse zu maximieren sind die Zusammenarbeit, Freigabe und Wiederverwendung. Veröffentlichte Ergebnisse und Best Practices können im gesamten Unternehmen für vorhandene und neue Prozesse und Applikationen eingesetzt werden. Damit sparen Kollegen Zeit für die Suche, Evaluation, Aggregationen und den zügigen Einsatz von Daten und Ergebnissen. Durch die Wiederverwendung vertrauenswürdiger Informationen steigt auch der Wert der Daten.

Entscheidend ist in diesem Zusammenhang eine datenzentrierte Sicherheit, die es Unternehmen ermöglicht, differenzierte Regeln für den Datenzugriff zu definieren, die über alle Anwender, Applikationen und Storage-Einheiten hinweg gelten. Die Sicherheitsfunktionen sollten es erlauben, granulare Zugriffsrichtlinien zu definieren, die Dateien, Tabellen, Spalten, Zeilen, Zellen oder Zellteilen zugeordnet werden können.

Vernetzung im Unternehmen fördern

Die Verknüpfung von Cloud-nativer und Big-Data-Anwendungsentwicklung mit Selfservice-Funktionalitäten für Datenanalysten bringt Fachbereiche und IT-Abteilung enger zusammen als bisher. Datenanalysten, nicht-technische Mitarbeiter aus den Fachbereichen, Applikationsentwickler und IT-Infrastrukturteams vernetzen sich und jede dieser Gruppen kann von den über einen Data Lake und die Cloud-Plattform bereitgestellten Daten und Tools profitieren – egal in welcher Branche.

Eine Hybrid Cloud, bei der die Applikationsentwicklungs- und Bereitstellungsplattform in der Cloud läuft und sich der Data Lake im Rechenzentrum eines Unternehmens befindet, trägt zur besseren Abstimmung zwischen der IT und den Fachbereichen bei. Durch die Verzahnung der Daten- und Analyseservices mit der Applikationsumgebung können Entwickler Erkenntnisse aus den Analysen rasch in neue Anwendungen umsetzen oder vorhandene erweitern.

Die Applikationen sind in der Lage, größere Datenvolumina zu erfassen und daraus neue Erkenntnisse zu generieren. Im nächsten Zyklusschritt fließen diese in die Datenanalyseprozesse ein, mit denen wiederum die Anwendungen weiter optimiert werden. Damit entsteht eine permanent optimierte Lösung, bei der die Entwicklung, die Implementierung, der Betrieb und die Verwaltung von Cloud-nativen Anwendungen vereinfacht werden und damit letztlich die Produktivität und betriebliche Effizienz in den Fachabteilungen steigen.