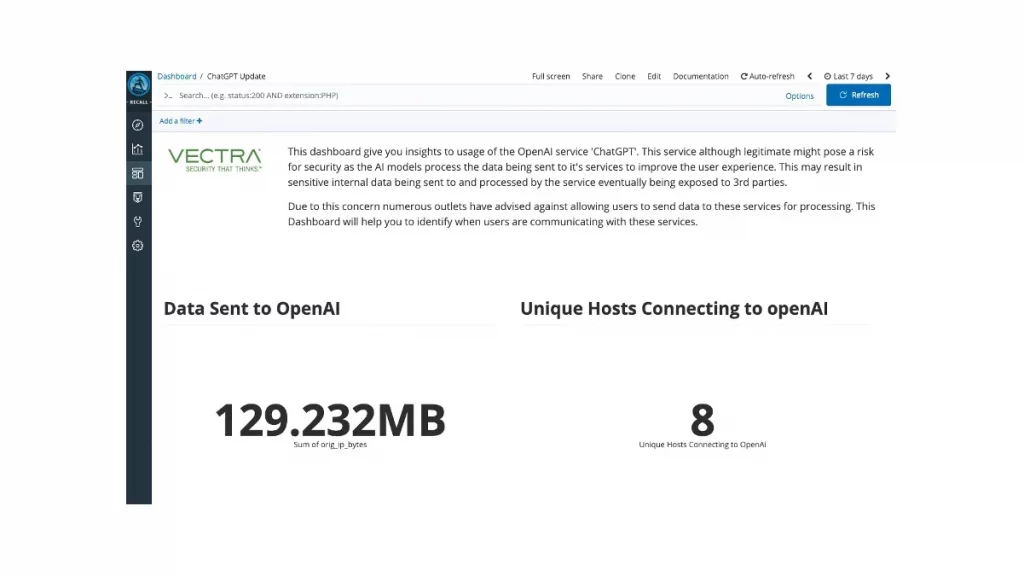

Dashboard zur ChatGPT-Nutzung im Unternehmen von Vectra AI

Large Language Models (LLMs) bringen eine große Zahl an Möglichkeiten mit sich. Sie ermöglichen beispielsweise das kostengünstige und schnelle Erstellen von Miniaturansichten für Blogs, das Übersetzen von Texten in andere Sprachen und den Umgang mit Kritikern. Ständig kommen neue Einsatzbereiche hinzu. Das bringt gleichzeitig das Problem mit sich, dass zur Zeit vollkommen unklar ist, welche Aufgaben die Technologie in Zukunft erfüllen wird, was wiederum zu greifbaren und ernsthaften Geschäftsrisiken führt.

Bei LLM denke viele Menschen zuerst an ChatGPT von OpenAI als das derzeit am einfachsten zugängliche und zu bedienende Tool. Mit ChatGPT kann jeder über einen Webbrowser Fragen stellen, und es generiert schnelle Antworten. Für den Durchschnittsnutzer ist das großartig, aber für jedes Unternehmen birgt diese Benutzerfreundlichkeit drei ernsthafte Probleme. Alle an ChatGPT gesendeten Daten werden von OpenAI zu Qualitäts- und Nachverfolgungszwecken gespeichert, die Quelle jeder Antwort ist unbekannt und die Antwort kann komplett erfunden sein.

OpenAI verfolgt die Eingaben der Nutzer, um sein Produkt zu verbessern und um einen eventuellen Missbrauch des Systems zu verhindern. Dies ist ein völlig vernünftiges Verhalten von OpenAI, aber es gibt keinen Grund zu glauben, dass OpenAI mit diesen Daten besonders sorgfältig umgeht. Darüber hinaus kann OpenAI nicht wirklich kontrollieren, welche Daten an ChatGPT übermittelt werden, so dass es Ende viele Informationen speichert, die eigentlich gar nicht gespeichert werden sollten. So kam zum Beispiel kürzlich ans Tageslicht, dass Samsung-Mitarbeiter ChatGPT zur Fehlersuche in firmeneigener Software und zur Zusammenfassung von Sitzungsprotokollen verwendet haben.

Das zweite Problem ist, dass ChatGPT Anfragen beantwortet, ohne Quellen für seine Antworten zu nennen. ChatGPT macht Aussagen, die auf seinen Erkenntnissen beruhen, und leider müssen Benutzer dies so hinnehmen, wie es ist. Diese Informationen könnten urheberrechtlich geschützt sein, und Benutzer würden es nicht wissen, bis sie ein Schreiben von Anwälten erhalten, die eine Verletzung des Urheberrechts behaupten. Getty Images hat den Ersteller eines Tools zur Erzeugung von LLM-Bildern wegen Urheberrechtsverletzung verklagt, nachdem festgestellt wurde, dass das Tool Bilder mit einem Wasserzeichen von Getty Images erzeugt hat. Es ist nicht unvernünftig zu argumentieren, dass alle Endnutzer, die diese Bilder verwenden, ebenfalls haftbar gemacht werden könnten. Die Codegenerierung ist ein weiterer Bereich, der Anlass zur Sorge gibt, auch wenn es bisher noch keine konkreten Beispiele gab, aber es scheint unvermeidlich.

Das größte Problem bei ChatGPT ist jedoch, dass diese LLMs „Halluzinationen“ haben können, was im Branchenjargon als „unverhohlene Lügen“ bezeichnet wird. Da ChatGPT keine Transparenz darüber hat, wie es zu den Antworten kommt, müssen die Nutzer in der Lage sein, die Antworten kritisch zu analysieren, um zu entscheiden, ob sie wahr sind, da ChatGPT und seinesgleichen immer mit absoluter Sicherheit antworten werden. Das kann Folgen haben, von Googles peinlichem Start bis hin zu einem Professor, der alle seine Studenten durchfallen ließ, nachdem ChatGPT fälschlicherweise behauptet hatte, studentische Arbeiten geschrieben zu haben – bis hin zum ungeheuerlichsten Beispiel, bei dem ein Anwalt ChatGPT benutzte, um seinen Schriftsatz vor Gericht zu verfassen, und ChatGPT sechs völlig falsche Quellen erfand, um das Argument zu stützen. Googles schlechtes Beispiel führte dazu, dass seine Marktbewertung um 100 Milliarden US-Dollar sank, der Universitätsprofessor seine Glaubwürdigkeit einbüßte und eine millionenschwere Klage vor Gericht möglicherweise abgewiesen wurde. Dies sind äußerst schwerwiegende Folgen, die eigentlich zu vermeiden wären.

Unternehmen reagieren auf diese Tatsachen mit Richtlinien, die die Verwendung von OpenAI ohne Genehmigung verbieten. Es ist jedoch schwierig, die Einhaltung dieser Richtlinien zu verfolgen, da der Datenverkehr über einen verschlüsselten Browser läuft, ohne dass eine Software erforderlich ist.

Einblicke in die Compliance durch ChatGPT Usage Dashboard

Vectra AI ist in der Lage, diese Aktivitäten im Netzwerk zu erkennen, indem es Netzwerksensoren zur Erkennung nutzt. Vectra NDR wurde entwickelt, um den gesamten Netzwerkverkehr im Unternehmen zu überwachen, mit sorgfältig platzierten Sensoren, die den Verkehr in und aus dem Netzwerk überwachen, aber auch innerhalb des Netzwerks selbst. Diese Analysetiefe ist die Grundlage für das leistungsfähige KI-gesteuerte Erkennungs-Framework und ermöglicht zudem aufschlussreiche Einblicke in die Compliance, zusammengefasst im ChatGPT Usage Dashboard.

Das Dashboard, das Vectra allen Plattformkunden kostenlos zur Verfügung steht, zeigt die Hosts in der Umgebung an, die aktiv mit OpenAI interagieren, indem es DNS-Anfragen an OpenAI-Server verfolgt, die von beliebigen Hosts gestellt werden. So können Compliance-Beauftragte nicht nur schnell eine Liste von Personen einsehen, die Konten bei OpenAI haben oder ein Interesse angemeldet haben, sondern auch aktiv überwachen, wer genau ein System nutzt und wie oft.

Das Dashboard nutzt die patentierte Vectra-Technologie zur Host-ID-Zuordnung, um diese Nutzer bis in die Tiefe zu verfolgen. Selbst wenn sich die IP-Adressen von Rechnern ändern oder ein Notebook einem neuen Netzwerk beitritt, verfolgt Vectra dies als denselben Rechner, so dass das Dashboard genau anzeigt, wie oft ein Gerät auf ChatGPT zugreift – was auch ermöglicht, schnell zu sehen, wen Vectra für den wahrscheinlichen Besitzer eines Rechners hält. Mit diesem Dashboard sehen Sicherheitsverantwortliche nicht nur, welche Hosts ChatGPT verwenden, sondern wissen auch, wen sie diesbezüglich kontaktieren müssen, und sie haben diese Informationen innerhalb von Minuten, nicht Stunden.

Dies ist nur ein Beispiel dafür, wie die Vectra-Plattform tiefe Einblicke in die Aktivitäten im Unternehmen bietet und zeigt, wie sie durch die Verfolgung aktiver Compliance-Probleme bei der Einhaltung von Vorschriften helfen kann. Dies erfolgt ebenso zuverlässig, wie das Certificate Expiry Dashboard, das ablaufende Zertifikate überwacht, die im Unternehmen aktiv genutzt werden, oder das Azure AD Chaos Dashboard, das MFA-Umgehungen überwacht. Vectra kann Compliance-Verantwortlichen wertvolle Einblicke bieten, nicht nur was im Unternehmen falsch konfiguriert ist, sondern welche Sicherheitsrisiken aktiv bestehen.

Weitere Informationen: https://www.vectra-ai.com/de