Sieben Schritte zu effektivem Datenmanagement für KI-Anwendungen

Der Erfolg von KI-Projekten hängt maßgeblich von der Qualität der verwendeten Daten ab, denn selbst die besten Modelle liefern ohne gut aufbereitete Informationen nur eingeschränkte Ergebnisse. Die Verwaltung, Prüfung, Aufbereitung und Bereitstellung großer Informationsmengen ist keine einfache Aufgabe und erfordert ein robustes Datenmanagement, das Technik und Prozesse berücksichtigt. Dell Technologies liefert einen Leitfaden für die Modernisierung des Datenmanagements, um Unternehmen die Bereitstellung qualitativ hochwertiger Daten für KI-Anwendungen zu ermöglichen.

Zentrale Maßnahmen sind die Festlegung konkreter Geschäftsziele, die schnelle Ermittlung relevanter Daten sowie die Vereinfachung des Zugriffs auf diese Daten, um Effizienz und Qualität zu steigern. Darüber hinaus sind iterative Optimierung der KI, Skalierung von Datenprodukten, Automatisierung von Data Governance und die Etablierung von Feedback-Schleifen entscheidend, damit Datenmanagement ein kontinuierlicher, lernender Prozess bleibt. Durch diesen strukturierten Ansatz lassen sich KI-Initiativen nachhaltig verbessern, der Wert der Unternehmensdaten maximal ausschöpfen und gleichzeitig Sicherheits- und Compliance-Risiken minimieren.

Konkrete Business-Ziele festlegen: Ohne eine klare Vision und konkrete geschäftliche Ziele können Unternehmen nur schwer einen Nutzen aus ihren Datenschätzen ziehen. Erst wenn sie wissen, was sie mit Daten und KI erreichen wollen, sind sie in der Lage, Anforderungen zu definieren und ihr Datenmanagement entsprechend anzupassen. Darüber hinaus benötigen sie Metriken, um zu überprüfen, ob die Maßnahmen wirksam sind und die angestrebten Ziele erreicht werden.

Ermittlung relevanter Daten beschleunigen: Viel hilft nicht immer viel. Wichtiger als die reine Menge an Informationen ist ihre Relevanz, weshalb Unternehmen genau die Daten schnell identifizieren müssen, die der Lösung eines Problems dienen. Das funktioniert am besten, wenn sie eine Verbindung zwischen Daten und ihrem Wert herstellen, indem sie Quelldatensätze katalogisieren und Metadaten erstellen. Dann kann die Datenauswahl und -bereitstellung effizient und effektiv erfolgen.

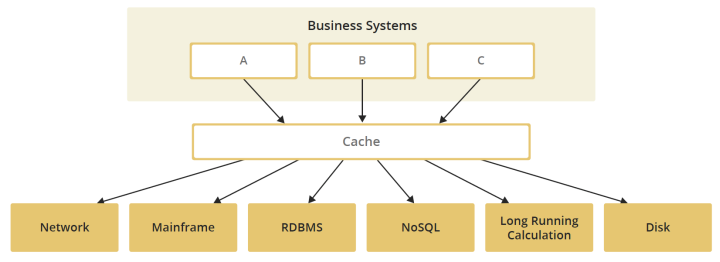

Datenexploration und -zugriff vereinfachen: Häufig werden Daten für Analysen auf zentralisierte Speicher verschoben, was ineffizient ist und Echtzeit-Auswertungen erschwert. Besser ist es, einen einheitlichen Zugriff auf die Originalspeicherorte zu ermöglichen, etwa mit modernen Architekturen wie einem Data Lakehouse. Sie ermöglichen es, Daten unabhängig vom Standort und der Datenquelle automatisch zu erkennen, einheitlich anzusprechen und in Echtzeit zu nutzen.

KI iterativ optimieren: Kontinuierliche Experimente und Modellierungen helfen, Datenvariablen zu identifizieren, die die Leistung der KI verbessern. Ein iterativer Prozess des Testens, Lernens und Verfeinerns sorgt letztlich dafür, dass die Modelle robust bleiben und Innovationen vorangetrieben werden können. Gerade für den KI-Einstieg sind vortrainierte Modelle ein guter Ausgangspunkt. Zudem können synthetisch generierte Daten helfen, Herausforderungen beim Datenschutz und der Datenqualität zu bewältigen und Prozesse in der Anfangsphase zu beschleunigen.

Datenprodukte und Analysen skalieren: Die Bereitstellung und Skalierung einfach nutzbarer Datenprodukte erleichtert es, aus einzelnen, isolierten KI- und Datenprojekten eine Projektpipeline aufzubauen, die eine immer weiter fortgeschrittene Datenwertschöpfung ermöglicht. Die Datenprodukte stellen eine effiziente und standardisierte Datenerfassung und -bereitstellung sicher, um Informationen schneller für Analysen zu nutzen, und können bei Bedarf leicht angepasst und optimiert werden.

Datenmanagement und Data Governance automatisieren: Wenn mehr und mehr Daten- und KI-Projekte umgesetzt werden, steigt der Aufwand bei der Verwaltung der Informationen und bei der Einhaltung von Compliance-Vorgaben. Deshalb ist es wichtig, Datenmanagement und Data Governance weitgehend zu automatisieren, sodass alle Workflows den vorgegebenen Standards, Richtlinien und Sicherheitsvorgaben folgen und Abweichungen vom System erkannt und gemeldet werden. Auf diese Weise gelingt die Datennutzung auch im großen Maßstab ohne Sicherheits- oder Compliance-Risiken.

Feedback-Schleife aufbauen: Um ihre Daten- und KI-Initiativen kontinuierlich weiterzuentwickeln und zu optimieren, müssen Unternehmen eine Kultur des Lernens und Anpassens fördern und regelmäßig überprüfen, ob ihre Initiativen die gewünschten Ergebnisse liefern. Auf diese Weise können sie zudem angepasst werden, falls sich die geschäftlichen Ziele verändern.

„Das Datenmanagement ist entscheidend für den Erfolg von Daten- und KI-Projekten“, betont Christian Winterfeldt, Senior Director Datacenter Sales DACH bei Dell Technologies. „Beim Datenmanagement handelt es sich allerdings um keine einmalige Aufgabe, sondern einen fortlaufenden Prozess, in dem Maßnahmen und Tools stetig verbessert werden, um die Datenwertschöpfung im Unternehmen voranzutreiben. Pauschallösungen gibt es dafür nicht, da jedes Unternehmen über eine einzigartige Datenlandschaft und ein individuelles Ökosystem aus Hardware und Software verfügt. Die Dell AI Factory mit NVIDIA vereint jedoch verschiedene Bausteine, sodass Unternehmen flexibel bleiben und die Technologie optimal an ihren geschäftlichen Anforderungen ausrichten können.“

Dell-Blog: https://www.delltechnologies.com/de-de/blog/